В целом, есть три наиболее важных тенденции в сфере сетевых решений, которые определяют развитие отрасли: конвергенция, технология распределенных вычислений (distributed networking) и программно-конфигурируемые сети (SDN). Это уже не новые темы, и с точки зрения зрелости технологии они постепенно становятся мэйнстримом.

Тем не менее, постоянно совершенствуются новые и открытые технологии, благодаря чему появляются и возможности для выбора. Поскольку ИТ-директора пытаются развивать свою сетевую стратегию, исходя из возможной выгоды от применения инновационных подходов, то чем новее и дешевле такие варианты по сравнению с традиционными архитектурами, тем быстрее они влияют на выбор и начинают менять «правила игры».

Конвергенция

Виртуализация в некоторой мере облегчила такой процесс благодаря своей гибкости. Однако это улучшение сопровождалось созданием новой роли – виртуализированного администратора, которому приходилось работать с множеством технологий от разных вендоров.

Настоящие решения на основе конвергентной инфраструктуры должны обладать такими характеристиками:

• Конвергентное управление: единые инфраструктурные операции для инфраструктурных команд, использующие простой и интуитивный инструментарий для повторяющихся, общих задач.

• Модели: гибкость для заказчиков обозначает простоту развертывания конвергентных систем, которая может ранжироваться от преинтеграции систем до подхода «сделай сам» (do-it-yourself, DIY).

• Полностью эталонные архитектуры: гибкие схемы для развертывания корпоративных приложений, VDI и частных облачных решений.

Подлинное конвергентное решение должно предоставлять обе опции: администраторы серверов должны иметь возможность управлять сетью, в то же время у сетевых администраторов должен быть доступ к серверной инфраструктуре. Гибкие инструменты на уровне контроллеров могут предоставить возможность конфигурации, которая бы приспосабливалась к домену в сети или предоставляла контроль серверному администратору. Следует подчеркнуть, что эта открытость – ключ к предоставлению гибкости, необходимой бизнесу.

Несмотря на то, что технология SDN (Software Defined Networking) еще в самом начале пути, программно-конфигурируемые сети уже признаны многими такой же революцией в сфере сетевой инфраструктуры, какой стала виртуализация в серверном сегменте. Традиционный подход к сетевой архитектуре уже не соответствует сегодняшним требованиям, поскольку администраторы требуют большей гибкости решений, а разработчики не могут трансформировать или усовершенствовать сетевые устройства, чтобы приложения могли еще лучше интегрироваться с сетевой инфраструктурой. Сетевые коммутаторы всегда работали с данными, используя ЦПУ, встроенное в сетевое аппаратное обеспечение. По сути это обозначает, что в руках ИТ-персонала находится лишь очень ограниченный контроль над потоком данных, находящихся в сети.

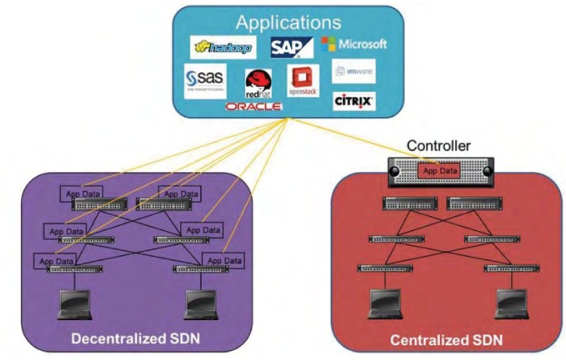

Отличия в функционировании децентрализованной и централизованной SDN-архитектуры

Появление SDN предоставило ИТ-администраторам контроллер, отделенный от коммутатора. Благодаря этому, они могут использовать и формировать потоки данных трафика без необходимости вручную настраивать отдельные части сетевого оборудования. Администраторы способны взять под контроль целые сети коммутаторов, используя эту единую панель управления. Все это обеспечивает гибкую виртуальную сетевую архитектуру, которая может идти в ногу с современными требованиями.Программно-конфигурируемые сети являются относительно новым термином, но их преимущества уже очевидны. Сетевые менеджеры теперь менее зависимы от дорогих проприетарных сетевых коммутаторов и маршрутизаторов, поскольку SDN может быть настроена на более дешевом оборудовании.

По своей сути Active Fabric предоставляет быструю, одноранговую сетевую архитектуру с полной взаимосвязанностью и резервными путями, гибкую и более подходящую для растущего объема трафика между узлами одного уровня (восток – запад) в современных виртуализированных ЦОД и приватных облаках. Подобные решения делают плоской традиционную архитектуру сети ЦОД, используя коммутаторы 10/40 Гбит/с с фиксированным форм-фактором, высокой плотностью компоновки и малой задержкой. Их можно быстро и просто внедрить, обеспечивая при этом наращивание сети до гипермасштабов.

SDN – это логичное расширение возможностей сети, которые предоставляют решения Active Fabric. Уровень абстракции ПО, обеспечиваемый принципами SDN, обеспечивает открытые возможности программирования, делая инфраструктуру более гибкой и адаптируемой к различным требованиям заказчиков. Кроме того, Dell является одним из немногих вендоров, предлагающих полный и объективный подход к SDN, охватывающий технологии Network Virtualization Overlay (NVO), OpenFlow и возможности унаследованных интерфейсов.

Вследствие нескольких последних тенденций традиционная централизованная сеть больше не соответствует потребностям бизнеса. Во-первых, рабочие ресурсы становятся все более мобильными, сотрудники теперь не сидят на месте. Во-вторых, виртуализация и облачные технологии меняют структуру сетевого трафика. И, наконец, предприятия сейчас оперируют намного большими потоками данных, чем когда-либо прежде.

Альтернативные распределенные сети, которые масштабируются намного легче, сейчас быстро завоевывают рынок. В сравнении с архитектурой традиционных сетей, подобные архитектуры могут быть масштабированы с использованием недорогих Ethernet-контроллеров. При этом архитектура остается надежной и предоставляет большую производительность при любом направлении потока.

Тем не менее, открытый подход к стандартам распределенных архитектур позволяет получить значительно большую степень гибкости. И это дает возможность ИТ-организациям смешивать и сочетать компоненты на основе потребностей и бюджетных возможностей.

Сетевое управление постоянно меняется и совершенствуется — и это создает новые возможности для трансформации бизнеса. Слишком долго конечные пользователи были ограждены проприетарными технологиями, которые тормозили инновации. Рост открытых стандартов, структур и архитектур наглядно подтверждает, что проприетарные модели теперь нельзя назвать оптимальными. В этом уверены заказчики, и такой ход мыслей дает возможность решать сегодняшние вызовы с помощью новых решений.