Тема энергосбережения и энергоэффективной производительности, о которой так часто в последнее время говорит Intel, как нельзя лучше сочетается с наметившейся в индустрии тенденцией расширения мощностей и введения в эксплуатацию новых центров обработки данных (ЦОД). Причиной тому постоянно растущие объемы информации, которые удваиваются каждые несколько лет. Их успешно генерируют неизменно увеличивающееся количество абонентов операторов мобильной связи, пользователей интернета, набирающие популярность принципиально новые сервисы и модели использования.

Aлександр Мельников: “Двухъядерные процессоры уже присутствуют во всех без исключениях продуктовых линейках Intel, а в некоторых даже недавно анонсированные четырехъядерные” |

Неудивительно, что Intel приняла самое активное участие в организованной нашим изданием конференции “ЦОД: построение и эксплуатация”. Специалисты компании поделились с присутствующими не только теоретическими сведениями об особенностях технологий, нацеленными на сокращение энергопотребления, но и практическим опытом создания ЦОД для собственных нужд. В то время как многие организации при внедрении ЦОД с высокой плотностью размещения компонент вынуждены прибегать к дорогостоящим и сложным в эксплуатации системам водяного охлаждения, Intel удается строить аналогичные решения с использованием воздушных кондиционеров.

Энергоэффективная производительность

Впрочем, с ростом вычислительной мощности ЦОД на первый план все чаще выходит даже не столько увеличение сложности системы кондиционирования воздуха или водяного охлаждения, сколько проблема оплаты астрономических счетов за электроэнергию. По оценкам аналитиков, в Европе они составляют около 100 тыс. евро в год для ЦОД аналогичной стоимости. В результате, компании вынуждены тратить львиную долю ИТ-бюджетов не на инновации, а на поддержание существующей инфраструктуры.

На фоне постоянного наращивания производительности процессоров в последнее время их разработчики вынуждены заботиться об эффективном расходовании электроэнергии. В частности, с недавних пор Intel даже ввела в обиход специальный термин — производительность из расчета на ватт потребляемой мощности. Новые продукты компании в несколько раз превосходят своих предшественников по этому показателю.

Повысить производительность при одновременном снижении энергопотребления позволил переход на более “тонкий” техпроцесс 65 нм. Он лежит в основе большинства современных процессоров Intel, а в следующем году появятся первые 45-нм модели. Дополнительный вклад в энергосбережение вносит применение так называемых “спящих” транзисторов и напряженного кремния, на смену которому скоро придут изоляторы с малой диэлектрической проницаемостью (low-k). Внедрение новой технологии даст возможность на несколько порядков уменьшить токи утечки — именно они негативно сказываются на энергопотреблении чипов.

Положительно на энергоэффективности современных процессоров сказывается переход от парадигмы дальнейшего наращивания тактовой частоты к увеличению количества ядер на кристалле. Однако в этой связи возникает новая проблема, связанная с необходимостью оптимизации существующего парка ПО к многопоточным вычислениям. Тем не менее, двухъядерные процессоры уже присутствуют во всех без исключениях продуктовых линейках Intel, а в некоторых даже недавно анонсированные четырехъядерные. По словам Александра Мельникова, специалиста по бизнес-решениям, его компания на ближайшие 5–10 лет избрала для себя прерогативой развитие направления по созданию многоядерных процессоров. Наглядный пример — демонстрация на последнем Intel Developer Forum (IDF) в Сан-Франциско прототипа 80-ядерного чипа.

Предметом особой гордости Intel стал повсеместный перевод в этом году х86-чипов на микроархитектуру Core, вобравшую в себя лучшие наработки двух предшественниц — Netburst и Banias. Она содержит целый ряд усовершенствований, направленных на повышение производительности процессоров и уменьшение их энергопотребления (см. PCWeek №6(24), с. 1). Взятый в 2005 году курс на платформизацию позволил не только оптимизировать энергопотребление готовых систем в целом, но интегрировать в них различные технологии: 64-разрядных вычислений EM64T, активного управления АМТ, ускорения операций ввода/вывода I/OAT, безопасности LaGrande и самую востребованную на сегодняшний день технологию виртуализации VT.

Intel предлагает четыре линейки двухъядерных серверных процессоров — Itanium серии 9100 и Xeon серии 7100, 5100 и 3100. Представители первой являются самыми высокопроизводительными и масштабируемыми и, как следствие, ориентированы на тяжелые приложения, например, базы данных (БД). Их компания позиционирует в качестве альтернативы для проприетарных систем, в настоящий момент под эту платформу портированы свыше 10 тыс. приложений. Xeon серии 7100 предназначены для построения многосокетных систем с числом процессоров от 4 до 32, а Xeon серии 5100 — для наиболее распространенных и популярных двухпроцессорных серверов. Наконец, Xeon серии 3100 позволяют строить однопроцессорные серверы начального уровня и рабочие станции.

ЦОД на примере Intel

Масштабы корпоративной ИТ-инфраструктуры Intel впечатляют — 210 тыс. узлов LAN, свыше 60 тыс. обычных и 6 тыс. инфраструктурных серверов, более 8 Пб хранимых данных, 40 млн. мин в месяц аудиопереговоров. На одного сотрудника службы технической поддержки в среднем приходится около 488 серверов. Компания имеет 124 офиса в 57 странах, ее штат включает свыше 98 тыс. постоянных сотрудников и 45 тыс. контрактных, она взаимодействует с более чем 350 клиентами и 10,2 тыс. поставщиками. За время своего существования Intel успела внедрить немало технологических и организационных нововведений: единые сеть, систему электронной почты, сетевую и клиентскую ОС, стандартные образы ОС, автоматическое распространение ПО, концепции электронного бизнеса и документооборота. В результате, специалисты Intel сумели накопить неоценимый практический опыт поддержания в рабочем состоянии огромного количества ИТ-ресурсов, в том числе ЦОД.

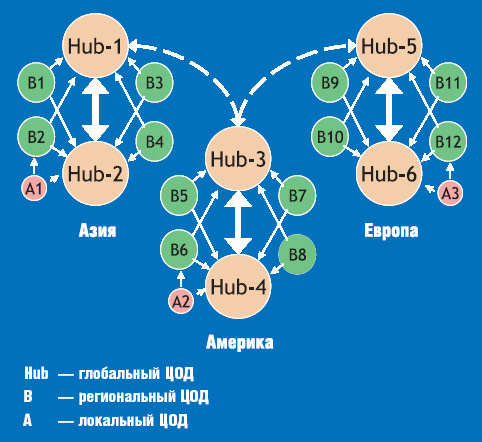

В рамках корпоративной ИТ-инфраструктуры Intel применяет модель ЦОД, ориентированную на масштабы и характер использования |

Как отметил Владимир Богданов, менеджер программы IT @ Intel в России и странах СНГ, проблемой большинства современных ЦОД остается недостаточно эффективное использование существующих систем кондиционирования. Многие из них в состоянии генерировать разницу температур 14–17°С, тогда как на практике она составляет всего 2,5°С. В то же время повышение эффективности систем охлаждения позволяет снизить первоначальную стоимость и уровень шума (за счет уменьшения количества устанавливаемого оборудования), стоимость эксплуатации (за счет уменьшения мощности оборудования) и дополнительно сократить занимаемую ЦОД площадь из расчета на кВт потребляемой мощности.

В традиционном ЦОД отдельный шкаф потребляет 2–4 кВт, что с учетом пространства, занимаемого системой кондиционирования, позволяет говорить о плотности энергии 67 Вт/(кв. фут). В таких системах между серверами в стойке присутствует свободное пространство, куда попадают потоки горячего воздуха, которые снижают эффективность системы охлаждения. В то же время свободное пространство в стойке можно заполнить дополнительными серверами, увеличив ее энергопотребление до 4–8 кВт, а плотность энергии — до 135 Вт/(кв. фут). Тем самым удается исключить паразитные воздушные потоки и нарастить вычислительные ресурсы на единицу площади.

Intel пошла еще дальше в своем стремлении увеличить эффективность ЦОД с воздушным охлаждением. Она провела работу с одним из поставщиков серверных шкафов и компании вместе пришли к необходимости увеличения их глубины для организации свободного пространства за установленным оборудованием. Верхняя панель этих chimney type cabinets спроектирована таким образом, что к ней можно подсоединить воздуховод и отводить с его помощью воздух в пространство за фальш-потолком и далее в системы охлаждения. Этот прогрессивный подход позволяет поднять мощность из расчета на шкаф до 8–14 кВт, а плотность энергии до 247 Вт на кв. фут.

В составе собственной ИТ-инфраструктуры Intel в одно- или двухэтажных зданиях успешно работают ЦОД высокой плотности, чьи шкафы потребляют 15 кВт при энергетической плотности 525 Вт/(кв. фут). Описанный подход построения ЦОД с полным разделением воздушных потоков позволяет сократить объемы циркулирующего воздуха, повысить эффективность работы системы кондиционирования и снизить связанные с ней капитальные и операционные затраты. Постоянная температура в помещении этих ЦОД составляет всего 20°С.

Итоги и перспективы

На последних IDF компания чрезвычайно много внимания уделяла теме ЦОД, в очередной раз подчеркивая важность этой темы для себя и индустрии в целом. Специалисты Intel работают над решением нетривиальных задач повышения эффективности блоков питания серверов, сокращения потерь электроэнергии при передаче к крупным ЦОД и анализа циркулирующих в центрах информационных пакетов для их защиты от внутренних угроз. Пакетирование памяти в одном корпусе с процессором, как это сделано в случае с прототипом 80-ядерного чипа, позволит в перспективе достичь еще более плотного размещения компонент ЦОД.

Результаты моделирования, полученные Intel, позволяют сделать несколько важных обобщений относительно организации систем охлаждения ЦОД:

• вынесение кондиционеров за пределы ЦОД повышает эффективность использования доступного пространства, при этом для фальшпола допустимо применять стандартные решетки без дополнительных увлажнителей;

• энергопотребление отдельного шкафа с серверами может достигать 30 кВт;

• подача холодного воздуха непосредственно в горячие области делает возможным применение относительно недорогих кондиционеров с разницей температур 25°С для охлаждения стоек с более существенной разницей 33°С;

• с другой стороны, внедрение более дорогих кондиционеров, обеспечивающих разницу температур 33°С, резко повышает эффективность системы воздушного охлаждения и максимально допустимую поверхностную плотность мощности ЦОД.

При строительстве ЦОД Intel использует модульный подход, который предполагает расширение центра по требованию и его полное соответствие плотности мощности 525 Вт/(кв. фут) и энергопотреблению шкафов на уровне 15 кВт. Оптимальными с точки зрения стоимости являются ЦОД, состоящие из пяти модулей — на их создание уходит немногим более 6 тыс. долл./кВт при среднем по индустрии значении около 13 тыс. долл./кВт. Модуль в интерпретации Intel означает пространство площадью 6 тыс. кв. футов, на котором размещено оборудование с общим энергопотреблением 3,2 МВт. Для сравнения ЦОД Hewlett-Packard потребляют 4 МВт, однако их площадь при этом составляет 25 тыс. кв. футов.

Приведенные в материале цифры справедливы исключительно для условий эксплуатации ЦОД Intel и основаны на расчетах компании совокупной стоимости владения (ТСО — Total Cost Ownership). Соответственно, результаты, получаемые с помощью альтернативных методик и подходов к составлению оценок в других компаниях, могут существенно отличаться. В любом случае непосредственно перед проектированием ЦОД очень важно четко представлять себе ближайшие планы по сокращению эксплуатационных расходов, определяющие характеристики серверных платформ, пути оптимизации системы охлаждения и воздушных потоков, расположения шкафов, подвода кабелей и т.д.

В рамках конференции “ЦОД: построение и эксплуатация” представители компаний спонсоров провели круглые столы для заинтересованных участников мероприятия. Владимир Богданов, менеджер программы IT @ Intel в России и странах СНГ, в своем докладе продолжил начатую на основной секции тему стратегического планирования ЦОД, уделив больше внимания различным практическим аспектам и вызвав тем самым оживленную дискуссию среди присутствующих ИТ-директоров компаний. После окончания круглого стола г-н Богданов ответил на несколько вопросов PCWeek/UE.

PCWeek/UE: Во время своего доклада Вы упомянули, что Intel удается создавать ЦОД с показателем долл./кВт порядка 3-6 тыс., в то время как средний показатель по отрасли 13 тыс. Каким образом стало возможным достичь такого выдающегося результата?

Владимир Богданов |

PCWeek/UE: Вы говорили о возможности построения эффективного ЦОД без фальшпола. Расскажите более подробно об этой возможности.

В. Б.: При начальном планировании ЦОД мы настоятельно рекомендуем предусматривать фальшпол, его отсутствие — только вынужденная мера. К ней приходится прибегать, если предстоит иметь дело с неприспособленным помещением, где построению полноценного фальшпола мешает, например, недостаточная высота потолков.

В этом случае существует несколько способов организации эффективного воздушного охлаждения. Первый состоит в ограждении горячих зон или применении шкафов с воздуховодами, которые не выпускают горячий воздух наружу. Второй подход позволяет решить проблему утечки горячего воздуха из зоны Hot Isle (Hot Isle — горячая область, зона в ЦОД, откуда забирают нагретый воздух для подачи в системы кондиционирования — прим. ред.) благодаря применению chimney type cabinets. Эти шкафы обладают большей глубиной, в результате, сзади остается свободное пространство. Необходимо использовать сетевые кабели с точно подобранной длиной, чтобы избежать образования бухт и петель. Горячий воздух из пространства за шкафом сразу уходит в пространство за фальшпотолком, откуда его забирают вентиляторы.

PCWeek/UE: Вы сами производите шкафы такого типа?

В. Б.: Бизнес Intel не связан с элементами инженерной инфраструктуры, при построении ЦОД мы используем стандартизированные серийные решения, которые свободно доступны на рынке. На данный момент полностью изолированные шкафы предлагает только один производитель, но мы провели переговоры со всеми европейскими и российскими разработчиками подобного оборудования и получили подтверждение готовности к созданию шкафов с закрытой циркуляцией воздуха.